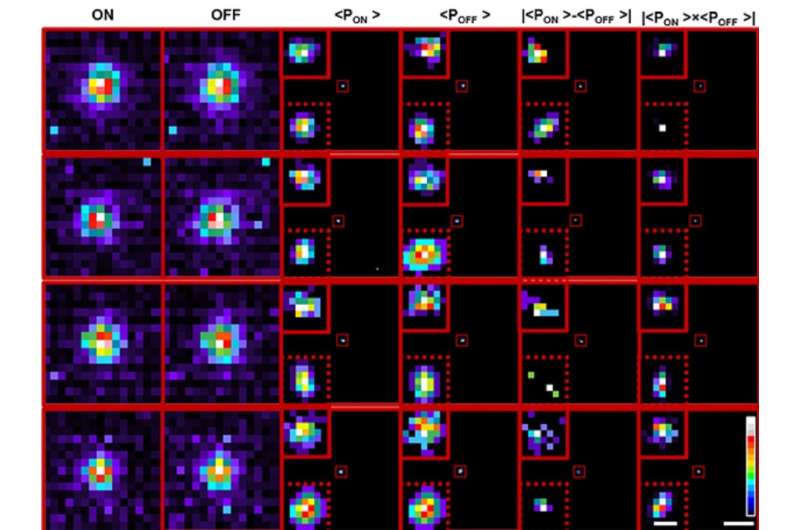

Transformatie van de cumulatieve waarschijnlijkheidsdichtheid van AAN- en UIT-processen maakt lokalisatie mogelijk onder de limiet van klassieke detectie van afzonderlijke deeltjes. Krediet: Mangalwedhekar et al

In een nieuwe studie laten onderzoekers van het Indian Institute of Science (IISc) zien hoe een door de hersenen geïnspireerde beeldsensor de diffractielimiet van licht kan overschrijden om minuscule objecten te detecteren, zoals cellulaire componenten of nanodeeltjes die onzichtbaar zijn voor de huidige microscopen. Hun nieuwe techniek, die optische microscopie combineert met een neuromorfe camera en machine learning-algoritmen, vormt een grote stap voorwaarts in het lokaliseren van objecten die kleiner zijn dan 50 nanometer. De resultaten worden gepubliceerd in Natuur Nanotechnologie.

Sinds de uitvinding van optische microscopen hebben wetenschappers ernaar gestreefd een barrière, de diffractielimiet genaamd, te overschrijden, wat betekent dat de microscoop geen onderscheid kan maken tussen twee objecten als ze kleiner zijn dan een bepaalde grootte (meestal 200-300 nanometer).

Hun inspanningen waren grotendeels gericht op het aanpassen van de moleculen die in beeld worden gebracht, of het ontwikkelen van betere verlichtingsstrategieën, waarvan sommige leidden tot de Nobelprijs voor scheikunde in 2014. “Maar zeer weinigen hebben daadwerkelijk geprobeerd de detector zelf te gebruiken om te proberen deze detectielimiet te overschrijden”, zegt Deepak Nair, universitair hoofddocent aan het Center for Neuroscience (CNS), IISc, en corresponderende auteur van het onderzoek.

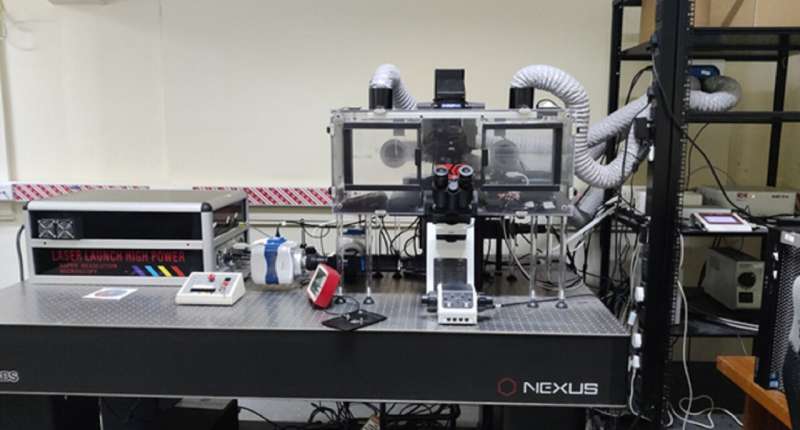

Met een afmeting van ongeveer 40 mm (hoogte) bij 60 mm (breedte) bij 25 mm (diameter) en een gewicht van ongeveer 100 gram, bootst de neuromorfische camera die in het onderzoek is gebruikt de manier na waarop het menselijk netvlies licht omzet in elektrische impulsen, en heeft verschillende voordelen boven conventionele camera’s. In een typische camera legt elke pixel de intensiteit vast van het licht dat erop valt gedurende de gehele belichtingstijd dat de camera op het object scherpstelt, en al deze pixels worden samengevoegd om een afbeelding van het object te reconstrueren.

In neuromorfe camera’s werkt elke pixel onafhankelijk en asynchroon, waarbij alleen gebeurtenissen of pieken worden gegenereerd wanneer er een verandering is in de intensiteit van het licht dat op die pixel valt. Dit genereert een schaarse en kleinere hoeveelheid gegevens in vergelijking met traditionele camera’s, die elke pixelwaarde met een vaste snelheid vastleggen, ongeacht of er enige verandering in de scène is.

Deze werking van een neuromorfe camera is vergelijkbaar met hoe het menselijk netvlies werkt, en stelt de camera in staat om de omgeving te “bemonsteren” met een veel hogere temporele resolutie – omdat deze niet wordt beperkt door een framesnelheid zoals normale camera’s – en ook om achtergrondonderdrukking uit te voeren.

Zicht op de microscopie-opstelling. Krediet: Rohit Mangalwedhekar

“Dergelijke neuromorfische camera’s hebben een zeer hoog dynamisch bereik (>120 dB), wat betekent dat je van een omgeving met zeer weinig licht naar omstandigheden met zeer veel licht kunt gaan. De combinatie van de asynchrone aard, het hoge dynamische bereik, schaarse gegevens, en hoge temporele resolutie van neuromorfe camera’s maken ze zeer geschikt voor gebruik in neuromorfe microscopie”, legt Chetan Singh Thakur, assistent-professor bij de afdeling Electronic Systems Engineering (DESE), IISc, en co-auteur uit.

In de huidige studie gebruikte de groep hun neuromorfische camera om individuele fluorescerende parels te lokaliseren die kleiner zijn dan de limiet van diffractie, door laserpulsen met zowel hoge als lage intensiteiten te laten schijnen en de variatie in de fluorescentieniveaus te meten. Naarmate de intensiteit toeneemt, registreert de camera het signaal als een “AAN”-gebeurtenis, terwijl een “UIT”-gebeurtenis wordt gerapporteerd wanneer de lichtintensiteit afneemt. De gegevens van deze gebeurtenissen werden samengevoegd om frames te reconstrueren.

Om de fluorescerende deeltjes binnen de frames nauwkeurig te lokaliseren, gebruikte het team twee methoden. De eerste was een deep learning-algoritme, getraind op ongeveer anderhalf miljoen beeldsimulaties die de experimentele gegevens goed weerspiegelden, om te voorspellen waar het zwaartepunt van het object zou kunnen zijn, legt Rohit Mangalwedhekar uit, voormalig onderzoeksstagiaire bij CNS en eerste auteur van de studie. Een wavelet-segmentatie-algoritme werd ook gebruikt om de zwaartepunten van de deeltjes afzonderlijk te bepalen voor de ON- en de OFF-gebeurtenissen. Door de voorspellingen van beide te combineren, kon het team nauwkeuriger inzoomen op de precieze locatie van het object dan met bestaande technieken.

“Bij biologische processen zoals zelforganisatie heb je moleculen die wisselen tussen willekeurige of gerichte beweging, of die geïmmobiliseerd zijn”, legt Nair uit. “Daarom moet je het vermogen hebben om het centrum van dit molecuul met de hoogst mogelijke precisie te lokaliseren, zodat we de vuistregels kunnen begrijpen die zelforganisatie mogelijk maken.”

Met deze techniek kon het team de beweging van een fluorescerende kraal die zich vrij in een waterige oplossing bewoog, nauwkeurig volgen. Deze benadering kan daarom wijdverbreide toepassingen hebben bij het nauwkeurig volgen en begrijpen van stochastische processen in de biologie, scheikunde en natuurkunde.

Meer informatie:

Rohit Mangalwedhekar et al, Precisie op nanoschaal bereiken met behulp van neuromorfe lokalisatiemicroscopie, Natuur Nanotechnologie (2023). DOI: 10.1038/s41565-022-01291-1

Tijdschrift informatie:

Natuur Nanotechnologie

Aangeboden door het Indiase Instituut voor Wetenschap